LLM再下一城!伯克利研究證明:OpenAI的o1被證明也具有匹敵人類語言學(xué)家的元分析能力。

在人類諸多才能之中,哪些才是人類所獨(dú)有的?

自古希臘哲人亞里士多德以來,語言便被視為最能彰顯人之本性的標(biāo)志。他曾言:人類乃「具有語言的動(dòng)物」。

即使當(dāng)今的大語言模型如ChatGPT已能在表層上模擬人類的日常言談,學(xué)者們依然追問:

在人類語言的深處,是否蘊(yùn)藏著某些獨(dú)特的結(jié)構(gòu)與特質(zhì),是任何其他生物的溝通方式,乃至AI的運(yùn)算體系,皆無法真正企及的?

加州大學(xué)伯克利分校語言學(xué)家、羅格斯大學(xué)的攜手,讓多個(gè)大語言模型經(jīng)受一系列語言學(xué)測(cè)試——其中包括要求模型歸納虛構(gòu)語言的規(guī)則。

雖然大多數(shù)大語言模型未能像人類那樣解析語言學(xué)規(guī)則,但有一個(gè)模型展現(xiàn)出遠(yuǎn)超預(yù)期的驚人能力。它能像語言學(xué)研究生那樣分析語言——劃分句子成分、解析多重歧義,并能運(yùn)用遞歸等復(fù)雜語言學(xué)特征。

研究者Gašper Beguš表示,這一發(fā)現(xiàn)「挑戰(zhàn)了我們對(duì)人工智能能力的認(rèn)知」。

AI會(huì)說話不稀奇,會(huì)解釋才稀奇——

如果語言是讓我們成為人類的關(guān)鍵,那么如今大語言模型獲得了「元語言」能力,這又意味著什么呢?

LLM構(gòu)建無窮遞歸

想象一下:你在搭一座一層套一層、像俄羅斯套娃一樣的「句子塔」。

每套進(jìn)一層,理解難度就指數(shù)級(jí)上升。

這種結(jié)構(gòu),在語言學(xué)里叫「中心嵌入」(center embedding),曾被知名語言學(xué)家喬姆斯基稱為能定義人類語言與思維的決定性特征。

比如這句話:

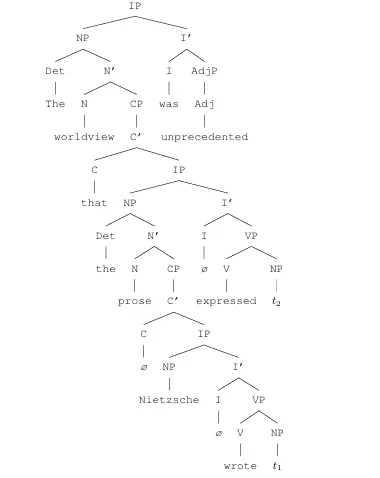

The worldview that the prose Nietzsche wrote expressed was unprecedented.

(大意為:尼采所寫的那篇散文所表達(dá)的世界觀是前所未有的。)

表面上看平平無奇,但如果你拆開它的「語言洋蔥」:

最外層:The worldview [...] was unprecedented(這個(gè)「世界觀」前所未有);

套進(jìn)去一層:that the prose [...] expressed(是「那篇散文所表達(dá)的」);

再往里一層:Nietzsche wrote(而這篇散文是「尼采寫的」)。

這就像在一個(gè)句子中間,又塞進(jìn)一個(gè)完整的句子,再在那個(gè)句子里塞進(jìn)另一個(gè)句子——三層套娃,層層遞歸。

人類能理解這樣的句子,但之前,人們認(rèn)為這樣的能力大模型不具備。

上述句子在真實(shí)對(duì)話中幾乎從未出現(xiàn)過——因?yàn)榇蠹視?huì)覺得它「太繞了!」

所以,任何語言模型如果只是靠「背書」,根本不可能見過,自然也無法識(shí)別出這種例子。

語言學(xué)家們認(rèn)為,人類語言從有限詞匯和有限規(guī)則中生成無限可能句子,這種能力歸因于無限遞歸。

迄今為止,還沒有令人信服的證據(jù)表明其他動(dòng)物能夠以復(fù)雜的方式使用遞歸。

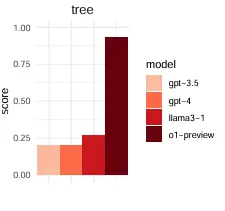

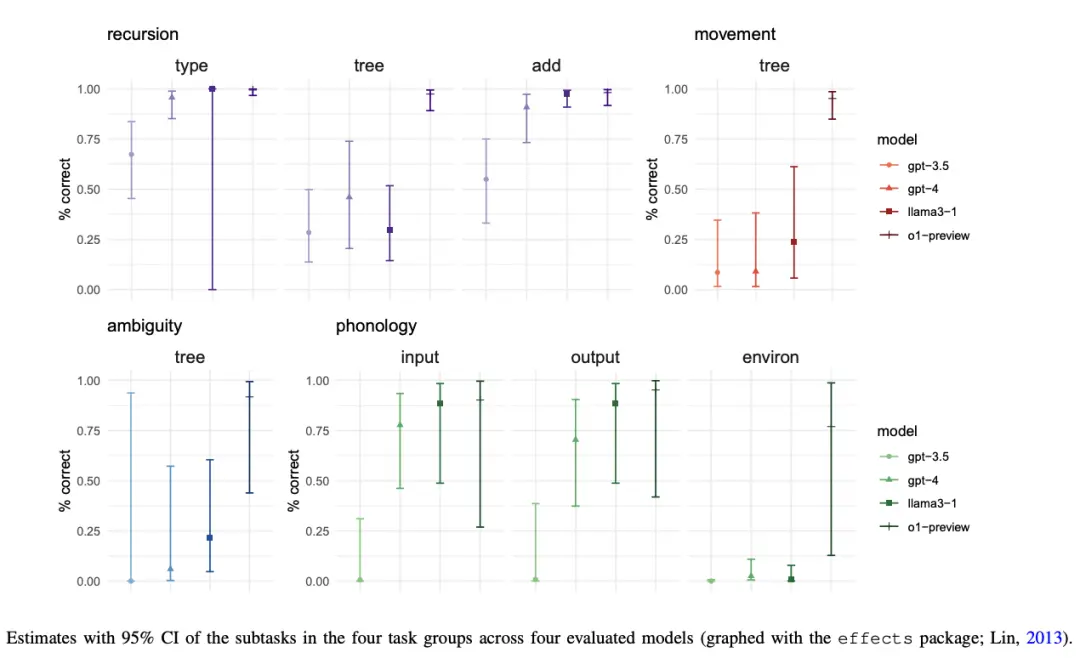

圖1:不同大模型識(shí)別多重遞歸,繪制正確語法樹的比例

然而,該研究指出在眾多大模型中,唯有OpenAI o1模型不僅看懂包含多重遞歸的句子(圖1)。

o1不僅能如同語言學(xué)家那樣,以接近100%的正確率畫出正確的樹狀結(jié)構(gòu),還能將本就復(fù)雜的句子變得更多一層。

圖2:該句子對(duì)應(yīng)的正確語法樹

當(dāng)它被問:「能不能再加一層遞歸?」o1回復(fù):

The worldview that the prose that the philosopher Nietzsche admired wrote expressed was unprecedented.

「那位尼采所敬仰的哲學(xué)家所撰寫的散文所表達(dá)的世界觀是前所未有的。」

這說明o1不僅能夠使用語言,還能夠思考語言,具備元語言能力(metalinguistic capacity )。

由于語言模型只是在預(yù)測(cè)句子中的下一個(gè)單詞,人對(duì)語言的深層理解在質(zhì)上有所不同。因此,一些語言學(xué)家表示,大模型實(shí)際上并沒有在處理語言。

這項(xiàng)研究的結(jié)論看起來是對(duì)上述觀點(diǎn)的否定。

大模型能區(qū)分歧義

也能深入理解句子

想象一下,你聽到下面的話:「Eliza wanted her cast out.」

乍一聽,好像就是「Eliza想把她的cast趕出去」?

但「cast」這個(gè)詞既可以是動(dòng)詞(「驅(qū)逐」),也可以是名詞(「石膏」)!

于是這句話就有兩種不同的含義,分別是

Eliza想要她的石膏被拿出去,

Eliza想把她趕出去。

這樣識(shí)別包含多義性句子的能力,之前同樣被認(rèn)為大模型不具備。

人類擁有很多常識(shí)知識(shí),使我們能夠排除歧義。但大模型很難具有這樣的常識(shí)知識(shí)水平。

然而該研究表明,o1可正確識(shí)別兩種結(jié)構(gòu),并為每種生成了符合語言學(xué)規(guī)劃的句法樹。其他模型(如 GPT-4、Llama 3.1)只會(huì)生成不合語法的結(jié)構(gòu),還會(huì)對(duì)語義產(chǎn)生誤解。

該研究還考察了大模型在音韻學(xué)相關(guān)任務(wù)上的表現(xiàn)——

音韻學(xué)是研究聲音模式以及最小的聲音單位,即音素的組織方式。

例如,在英語中,給以「g」結(jié)尾的詞加上「s」會(huì)發(fā)出「z」的音,就像「dogs」一樣。但給以「t」結(jié)尾的詞加上「s」聽起來更像標(biāo)準(zhǔn)的「s」音,就像「cats」一樣。

該研究一口氣創(chuàng)建了30種新的迷你語言,以了解大模型是否能夠在面對(duì)新生成的虛擬語言時(shí),在沒有任何先驗(yàn)知識(shí)的情況下能不能正確推斷語音規(guī)則。

結(jié)果出人意料,即使是在這些虛構(gòu)的語言上,o1在音韻相關(guān)的任務(wù)上表現(xiàn)依舊出色。

大模型比人類更好地理解語言嗎?

從上述三個(gè)例子可以看出,曾經(jīng)那些被認(rèn)為僅僅人類能夠擁有的語言理解能力,大模型如今也具備了。

2023 年著名語言學(xué)家喬姆斯基在《紐約時(shí)報(bào)》上寫道:「語言的正確解釋很復(fù)雜,不能僅僅通過浸泡在大數(shù)據(jù)中就能學(xué)會(huì)。」

該文認(rèn)為盡管 AI 模型在運(yùn)用語言方面可能很擅長,但它們并不具備以復(fù)雜方式分析語言的能力。

在此思潮影響下,即使ChatGPT在各方面上復(fù)制了自然語言,公眾仍想知道大模型是否有人類語言的特定特征能不能由大模型復(fù)現(xiàn)。

這當(dāng)然很有必要,隨著社會(huì)越來越依賴大模型,了解它在哪些方面能成功以及哪些方面會(huì)失敗變得越來越重要。

語言分析是評(píng)估語言模型推理能力與人類相似程度的理想測(cè)試平臺(tái)。

而o1能夠以與語言學(xué)家相似的方式分析語言,例如繪制句子圖、解決多個(gè)歧義含義,并利用遞歸等復(fù)雜的語言特征

但我們發(fā)現(xiàn)這一現(xiàn)象后,人們不禁會(huì)問下面兩個(gè)問題:

第一個(gè)問題是為何只有o1可行,其它大模型表現(xiàn)都差一大截。

回答是相比其它模型,o1 的優(yōu)勢(shì)很可能源于思維鏈(類似Deepseek的深度思考),使其能像人類語言學(xué)家一樣逐步推理、驗(yàn)證假設(shè)、構(gòu)建抽象規(guī)則。

第二個(gè)問題是當(dāng)模型的性能隨著規(guī)模變大而變大時(shí),大模型是否有一天會(huì)比我們更能準(zhǔn)確的理解語言嗎?

對(duì)于這個(gè)問題的回答,目前還沒有定論。

一方面,任何的大模型在語言學(xué)上還沒有提出過原創(chuàng)性的觀點(diǎn),也沒有教給我們關(guān)于語言的新知識(shí)。

另一方面,增加計(jì)算能力和訓(xùn)練數(shù)據(jù),語言模型最終會(huì)在語言技能上超越我們, 看不出有什么理由阻止語言模型展現(xiàn)出比我們更好的語言理解能力。

研究尚不足以宣稱「機(jī)器理解語言勝于人類」,但足以改變?cè)u(píng)價(jià)口徑:對(duì)模型的考察,應(yīng)從「任務(wù)產(chǎn)出」轉(zhuǎn)向「結(jié)構(gòu)解釋」。

當(dāng)可解釋性成為首要指標(biāo),AI研究、教育與應(yīng)用治理將迎來同一套標(biāo)準(zhǔn)——把「為什么對(duì)」放在「對(duì)不對(duì)」之前。